最近よく目にすることになったAI生成ツール。

OpenAI社のChatGPTをはじめとして、Google社の「Gemini(旧Bard)」、Microsoft社の「Copilot」など、各社が次々にAIツールを開発しています。

情報収集や疑問の解決など便利になった反面、次に出てくるのが反対に”記事をパクられてしまう問題”です。

丹精込めて書いた記事がそのままAIによって学習され、盗用されてしまうことほど、腹立たしいことはないでしょう。

そこで本記事では、WordPress利用者向けに、主要なAIツールからブログ記事をパクられなくする方法をご紹介します。

-150x150.png) ユミ

ユミrobots.txtにコードを記載するだけでOKですよ。

robots.txtとは?

AIツールからブログ記事をパクられなくするには、robots.txtに、AIクローラーをブロックするためのコードを記載するだけです。

robots.txtができることは、以下の通り。

- 検索エンジンのクローラーを制御する…検索エンジンのボットに対して、特定のページへのクロールを許可または禁止する。

- 特定のクローラーをブロックする…悪意のあるボットや不要なクローラーがサイトにアクセスするのを防ぐ。

- クロールしてほしくないファイルを指定する…機密情報や非公開ページなど、特定のファイルやディレクトリのクロールを禁止する。

robots.txtは、検索エンジンのクローラーを特定のページにアクセスすることを防ぐためのテキストファイルです。

このファイルの格納場所は、ウェブサイトのルートディレクトリ。(例:https://abcdef.com/robots.txt)

その箇所にあるrobots.txtを変更すれば、どのページに対してクローラーに来てほしくないかを指定することができます。

ただし、robots.txtに記載した内容は必ず守られるというものではなく、一部のクローラーや悪意のあるボットは無視する可能性もあります。

そのため完璧な対策にはなりませんが、それでも一定の効果は見込めるでしょう。

-150x150.png)

-150x150.png)

-150x150.png)

実際にこの設定をしたことで、記事の盗用がなくなったケースも!

AIツールからブログ記事をパクられた問題を解決する方法【WordPress】

robots.txtファイルを編集するには、

- プラグインを利用してrobots.txtを編集する

- FTPソフトやサーバーのファイルマネージャーを使用して、robots.txtファイルをアップロードする

このどちらかの方法で行うことができます。

ただし、パーマリンクが「基本」のまま設定されていたり、WordPressがサブディレクトリにインストールされている場合は、robots.txtが生成されない可能性があります。

ここでは、私が推奨する最も簡単な方法をご紹介しますね。

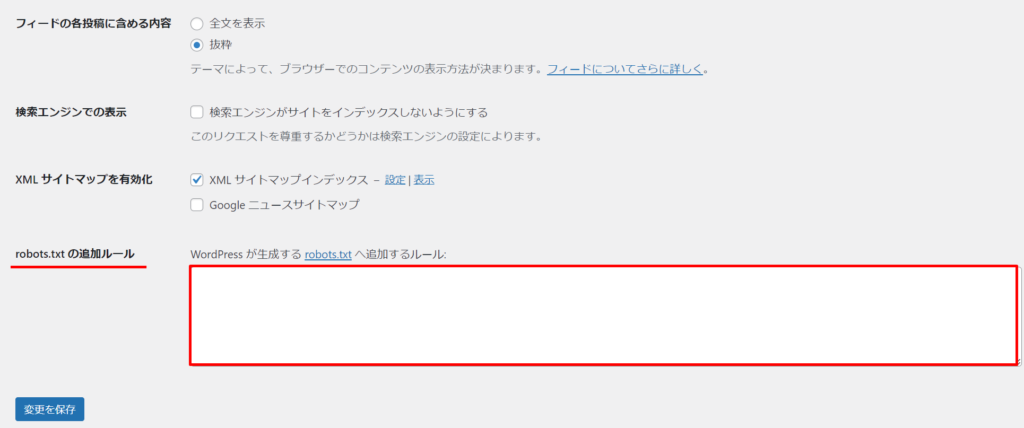

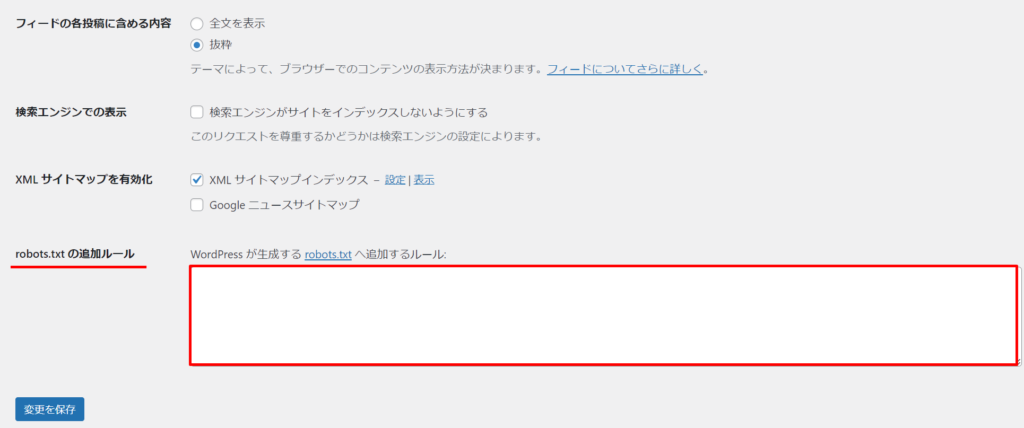

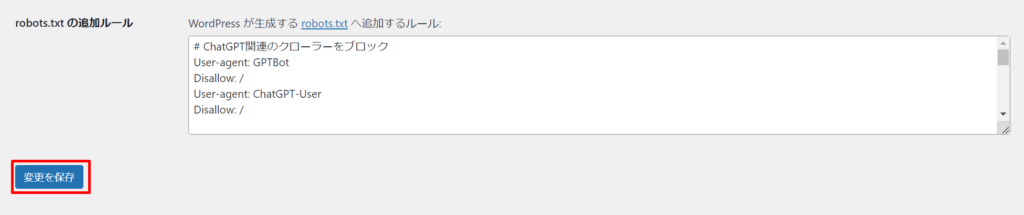

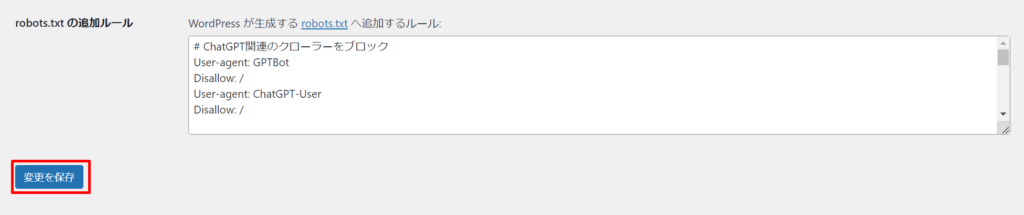

「XML Sitemap & Google News」というプラグインにてサイトマップ設定を行っている方であれば、WordPressの「設定」画面からrobots.txtの記述ができます。

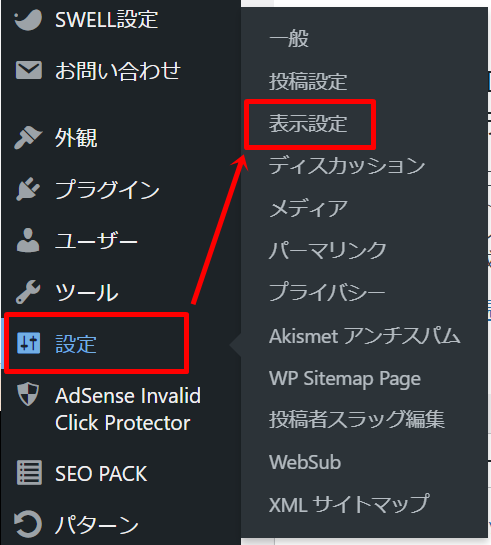

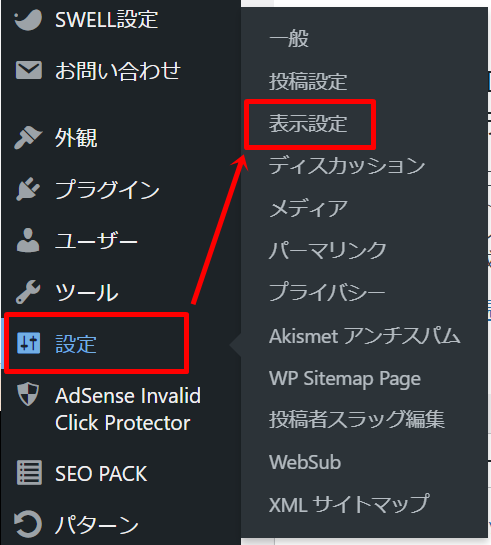

「設定」→「表示設定」へ。

一番下に「robots.txt の追加ルール」という項目を確認できます。

ここにコードを記載するただけで、反映されるようになっています。

以下が、それぞれのAIボットを拒否するコードですので、コピペで追加していきましょう。

# ChatGPT関連のクローラーをブロック User-agent: GPTBot Disallow: / User-agent: ChatGPT-User Disallow: / # ClaudeBot関連のクローラーをブロック User-agent: ClaudeBot Disallow: / # Google-Extendedを含むGoogleのクローラーをブロック User-agent: Google-Extended Disallow: / # Microsoftの生成AI(Copilotなど)のクローラーをブロック User-agent: Bingbot Disallow: / User-agent: BingPreview Disallow: / # Common Crawlのクローラーをブロック User-agent: CCBot Disallow: /

-150x150.png)

-150x150.png)

-150x150.png)

必要に応じて追加や削除をしてもOK!

追加したら、忘れず「変更を保存」しておきましょう。

あとがき

今回は、AIツールからブログ記事を守る方法についてでした。

robots.txtの設定をしたからといって必ず安全というわけではありませんが、一定の効果は見込めるでしょう。

設定も簡単ですので、WordPressでサイトを作ったら念のため対策しておかれると安心ですね。

無断で複製・盗用されないよう、できる限りの対策をしておきましょう!

AIツールではなく人為的に記事がパクられた場合は、以下の方法も併せて行ってみてください。

コメント